Google suele explicar con bastante frecuencia cómo trabaja con distintos modelos de aprendizaje automático para mejorar el funcionamiento de sus aplicaciones. Lo hizo recientemente explicando cómo funcionaban los radares de Soli y ahora explica cómo funcionan las nuevas mejoras en calidad de audio de Google Duo.

Lo ha logrado con un nuevo modelo llamado WaveNetEQ, un sistema generativo basado en la tecnología de DeepMind capaz de completar los paquetes perdidos en las ondas de voz. Veamos cómo logra Google tal hazaña.

Así mejora Google la calidad de audio en Duo a través de un modelo generativo

Google cuenta que, cuando se envían paquetes de datos por internet, es sencillo que haya errores a la hora de recibirlos.

Google cuenta que, cuando se envían paquetes de datos por internet, es sencillo que haya errores a la hora de recibirlos.

Google cuenta que cuando se transmite una llamada a través de internet los paquetes tienen ciertos problemas de calidad. Estos problemas se deben a fluctuaciones excesivas o retrasos en la red, pudiendo llegar a perderse hasta un 8% del contenido total debido e estos.

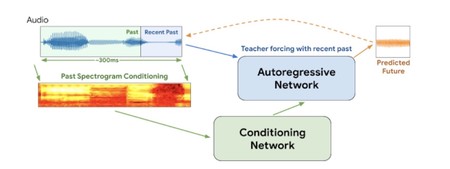

Para asegurarse de que la comunicación funciona correctamente a tiempo real, Google ha creado WaveNetEQ, un sistema PLC (controlador lógico programable) entrenado con una generosa base de datos de voz. ¿Qué hace este modelo? La explicación es bastante técnica y compleja, así que vamos a resumirla de la forma más sencilla.

El sistema de Google analiza los paquetes de audio para tratar de predecir lo que se quiere decir. Con esta información procesada en redes neuronales, se completa el espectro de onda que falta.

El sistema de Google analiza los paquetes de audio para tratar de predecir lo que se quiere decir. Con esta información procesada en redes neuronales, se completa el espectro de onda que falta.

WaveNetEQ es un modelo generativo que permite sintetizar las ondas de voz incluso aunque se hayan perdido partes de dicha onda. Seguramente alguna vez hayas tenido mala calidad en videollamada y hayas oído un sonido robótico o metalizado. Este se debe a cuando la falta de paquetes es alta (hay mucha latencia) y el sonido no puede reproducirse con calidad.

Mediante redes neuronales Google es capaz de darle continuidad a la señal a tiempo real, minimizando la pérdida de calidad. Básicamente, gracias a la base de datos de voz, el modelo "adivina" lo que se pretende decir y completa la onda con los fragmentos que faltan.

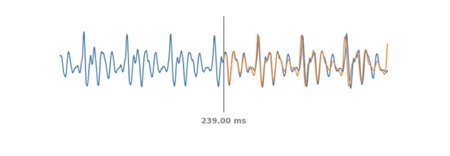

En azul la línea de audio original. En naranja, las líneas que Google predice.

En azul la línea de audio original. En naranja, las líneas que Google predice.

Estas mejoras se empiezan a aplicar ya en Google Duo en los Google Pixel 4, aunque la compañía asegura que el modelo llegará al resto de terminales dentro de poco, por lo que será una mejora de la aplicación, no solo de los dispositivos.

Más información | Google

Ver 3 comentarios